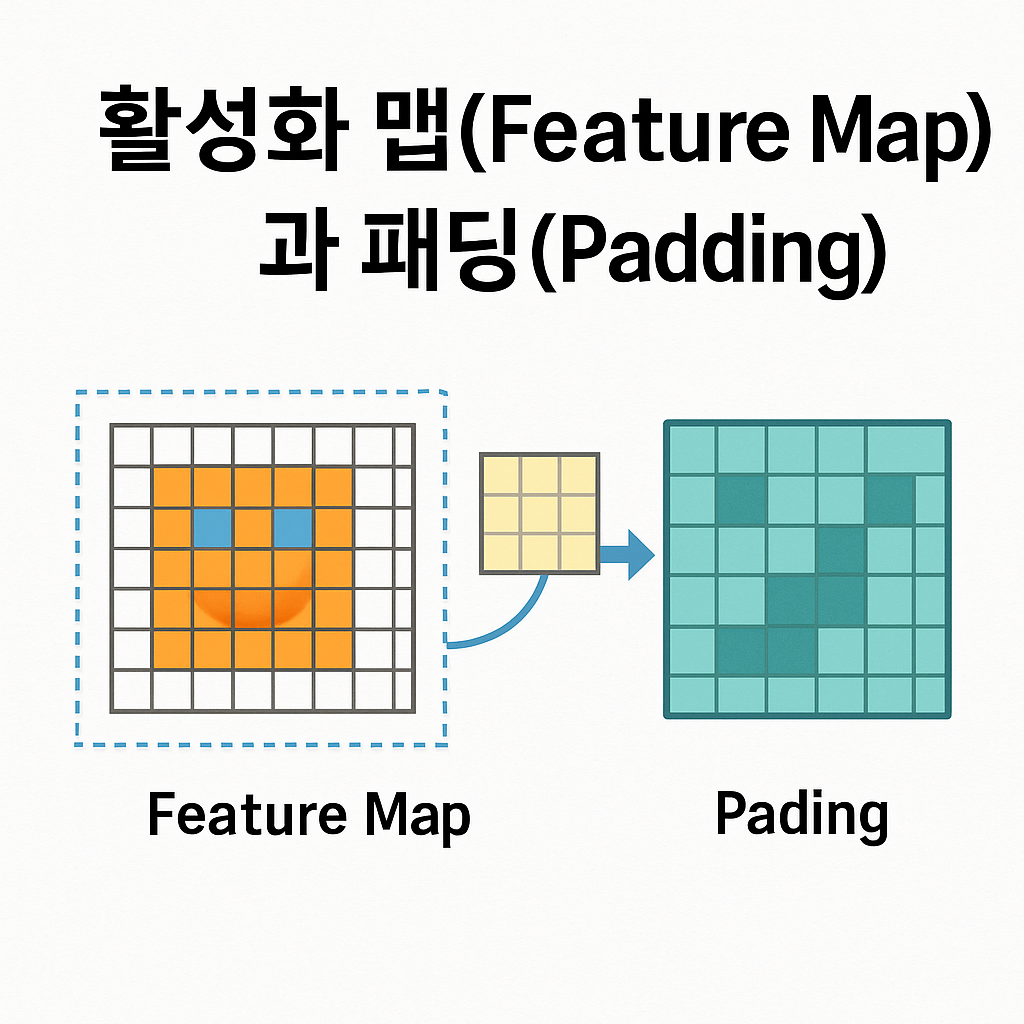

활성화 맵(Feature Map)과 패딩(Padding)의 개념과 원리

이미지 속 정보를 정확히 뽑아내는 비결?

바로 활성화 맵과 패딩에 숨어 있습니다.

CNN을 제대로 이해하려면, 이 두 개념은 꼭 짚고 넘어가야 해요!

안녕하세요! 오늘은 합성곱 신경망(CNN)의 핵심 구조 중 하나인 활성화 맵(Feature Map)과 패딩(Padding)에 대해 이야기해보려 해요. 이 두 가지는 초보자분들이 가장 혼란스러워하는 개념 중 하나지만, 한 번 이해하면 CNN의 동작 원리가 훨씬 선명하게 보이기 시작하죠. 실전 예제와 함께 천천히 하나씩 풀어보면서, 여러분도 자신만의 인사이트를 발견하게 될 거예요. 그럼, 같이 출발해볼까요? 😊

목차

1. 활성화 맵(Feature Map)이란? 🔍

활성화 맵(Feature Map)은 합성곱 신경망(CNN)에서 합성곱 연산(convolution)을 통해 입력 이미지에서 특정 특징(Feature)을 추출한 결과를 의미해요. 쉽게 말하면, 필터(또는 커널)가 이미지를 스캔하면서 "여기! 특징이 있다!" 라고 반응한 결과값이죠.

📌 핵심 포인트: Feature Map이란?

- CNN의 각 합성곱 계층에서 생성되는 출력 이미지이다.

- 각 Feature Map은 하나의 필터가 감지한 특정 특징 정보를 담고 있다.

- 보통 여러 개의 필터를 사용하기 때문에, 여러 개의 Feature Map이 동시에 생성된다.

🧠 직관적으로 이해해볼까요?

사진 속 고양이를 CNN에 입력했을 때, 어떤 필터는 수염에 반응하고, 어떤 필터는 눈동자에 반응해요. 각 필터가 반응한 정도(=값)를 모아 놓은 것이 바로 Feature Map입니다. 어떤 부분에 "주목했는지"를 시각적으로 보여주는 셀프 지도처럼 생각하면 쉬워요.

📊 수식이 궁금한 분들을 위해!

간단한 수식으로 보면, Feature Map의 각 픽셀은 다음처럼 계산돼요.

Output(i, j) = ∑∑ Input(i+m, j+n) × Filter(m, n)

여기서 Input은 입력 이미지, Filter는 합성곱 필터(커널), (i,j)는 출력 위치입니다. 입력의 특정 부분을 필터가 스캔하며 곱하고 더한 결과가 출력이 되죠!

📌 정리해볼까요?

| 구분 | 설명 |

|---|---|

| Feature Map | 입력 이미지에서 필터가 감지한 특징 정보의 모음 |

| 형태 | 2D 행렬 또는 여러 개의 2D Feature Map(Stack) |

| 의미 | CNN이 입력에서 어떤 패턴에 주목하고 있는지를 보여줌 |

이제 Feature Map이 뭐고, 왜 중요한지 감이 오시나요? 다음은 실제 예제와 함께 Feature Map이 어떻게 만들어지는지 살펴볼 거예요. 함께 계속 가볼까요? 🚀

2. 실제 예제로 보는 Feature Map 📷

이론만으로는 조금 어렵게 느껴졌다면, 걱정 마세요! 이제 직접 눈으로 확인할 수 있는 예제를 함께 보면서 Feature Map이 실제로 어떻게 생성되는지 이해해볼게요.

🎯 예제: 5x5 이미지와 3x3 필터

다음은 5x5 이미지와 3x3 필터를 사용해 Feature Map을 생성하는 예제입니다.

입력 이미지와 필터가 어떻게 작용하는지 순서대로 볼게요.

| 입력 이미지 (5x5) | 필터 (3x3) | 출력 Feature Map (3x3) |

|---|---|---|

|

|

|

🧠 어떤 일이 일어난 걸까요?

필터는 이미지의 가장 왼쪽 위부터 시작해서 오른쪽으로, 그리고 아래로 이동하면서 입력값과 필터값을 곱하고 더한 값을 Feature Map에 기록했어요. 이 과정을 스트라이드 1이라고 부릅니다.

🖥 Orange Data Mining에서 구현할 수 있을까?

네! Orange에서는 직접 필터값을 조정하거나 Feature Map을 수치로 계산하진 않지만, 이미지 임베딩(Image Embedding) 기능을 통해 사전 학습된 모델의 Feature 추출 결과를 시각화할 수 있어요.

- 이미지 → Image Embedding 위젯 → t-SNE로 Feature Map 시각화

- CNN의 중간 계층에서 추출된 특징 벡터(Feature Vector)를 시각적으로 확인 가능

Feature Map이 어떻게 생성되고, 어떤 역할을 하는지 감이 좀 오셨죠? 다음은 Feature Map을 만들 때 자주 등장하는 패딩(Padding)에 대해 알아보겠습니다. 👉

3. 패딩(Padding)의 정의와 필요성 ➕

패딩(Padding)은 말 그대로 입력 이미지의 가장자리를 감싸는 ‘여백’이에요. 왜 굳이 여백을 추가할까요? 사실 이건 CNN에서 굉장히 중요한 역할을 해요. 초보자들이 자주 놓치는 부분이기도 하구요.

🤔 왜 패딩이 필요할까?

- 출력 크기 유지 – 합성곱을 적용하면 입력 이미지보다 출력 크기가 작아져요. 이를 방지하려면 테두리를 채워줘야 해요.

- 가장자리 정보 보존 – 입력 이미지의 바깥쪽 정보도 CNN이 인식할 수 있도록 도와줘요.

- 모델 깊이 조절 – 연속적인 합성곱 계층에도 출력 크기를 조절할 수 있어요.

🧮 수식으로 보면?

합성곱 결과의 출력 크기 공식은 다음과 같아요:

Output size = ((Input size - Filter size + 2 × Padding) / Stride) + 1

이 공식을 보면, 패딩을 줘야 출력 크기를 조절할 수 있단 걸 알 수 있죠!

🧵 Padding을 안 주면 어떻게 될까?

예를 들어, 5×5 입력에 3×3 필터를 적용하면, 출력은 3×3으로 줄어들어요. 다음 계층에 또 3×3 필터를 적용하면 1×1… 그 다음은? 끝! 😱 그래서 깊은 신경망을 구성하려면 패딩이 필수예요.

📎 CNN 실전에서 패딩이 없으면?

모델이 이미지 중앙에만 집중하고, 테두리나 구석 정보는 무시하게 될 수 있어요. 정확한 분류와 객체 검출에 큰 손해가 되죠.

다음 단계에서는 다양한 패딩의 종류를 표로 비교해볼게요. 어떤 상황에서 어떤 패딩을 써야 하는지도 같이 정리해보겠습니다!

4. 다양한 패딩 종류 비교표 🔢

CNN에서 사용하는 패딩의 종류는 딱 두 가지가 가장 일반적이에요. ‘VALID’ 패딩과 ‘SAME’ 패딩. 이름이 생소해서 어렵게 느껴질 수 있지만, 실제로는 아주 간단해요! 아래 표로 정리해볼게요.

| 패딩 종류 | 설명 | 특징 | 출력 크기 |

|---|---|---|---|

| VALID | 패딩 없이 합성곱 수행 (즉, 바깥 테두리는 무시됨) | 출력이 작아짐, 가장자리 정보 손실 | (Input - Filter) / Stride + 1 |

| SAME | 입력과 출력 크기를 같게 만들기 위해 0으로 패딩 추가 | 가장자리 보존, 출력 크기 유지 | ceil(Input / Stride) |

💡 어떤 걸 써야 할까?

초보자라면 SAME 패딩을 먼저 사용하는 걸 추천해요. 구조를 단순하게 만들 수 있고, 출력 크기를 유지하니까 결과 확인도 훨씬 쉬워요.

- 이미지 크기를 그대로 유지하면서 처리하고 싶다면 → SAME

- 정확한 특징만 뽑고, 출력 크기 줄어드는 걸 감수할 수 있다면 → VALID

🧩 참고: 커널 사이즈, 스트라이드, 패딩의 관계

CNN 구조를 설계할 때 가장 헷갈리는 부분이 이 3가지예요. 출력 크기가 달라질 수 있기 때문에 항상 계산을 잘해야 합니다. 특히 모델을 쌓을수록 그 차이가 누적되기 때문에, 실무에서는 SAME 패딩과 stride=1 조합을 많이 사용해요.

이제 어떤 패딩을 쓸지 스스로 판단할 수 있을 거예요! 다음은 Orange에서 이러한 구조를 시각적으로 어떻게 다루는지 실제 사례를 살펴보죠 🎨

5. Orange에서의 Feature Map과 Padding 구현 🎨

Orange Data Mining은 GUI 기반의 시각화 중심 도구이기 때문에 TensorFlow나 PyTorch처럼 직접 CNN 구조를 설계하진 않지만, 이미지 특징 추출과 시각화에는 정말 탁월한 툴이에요. 특히 Image Embedding과 t-SNE 위젯을 조합하면, Feature Map의 개념을 직관적으로 이해할 수 있어요.

📌 구현 워크플로우 예시

- 1️⃣ Import Images 위젯으로 이미지 데이터 불러오기 (예: 손글씨 숫자, 꽃 이미지 등)

- 2️⃣ Image Embedding 위젯을 연결해 사전학습된 CNN 모델로 특징 추출

- 3️⃣ t-SNE 위젯을 활용해 추출된 특징들을 2D로 시각화

- 4️⃣ Image Viewer를 연결해 어떤 이미지가 어떤 특징 공간에 있는지 확인

🧠 이게 왜 중요할까요?

CNN 내부에서 어떤 Feature Map이 만들어지는지는 직접 볼 수 없지만, 이미지 임베딩 결과는 우리가 관심 있는 특징(고양이 귀, 꽃잎 모양 등)을 반영해서 시각적으로 분류되어 있어요. 이는 CNN이 어떻게 시각적 특징을 학습하는지를 직관적으로 보여주는 셈이죠.

Orange는 사용자가 직접 패딩을 조절할 수는 없지만, 모델 학습 시 자동으로 처리되는 구조 덕분에 복잡한 세팅 없이도 CNN의 원리를 체험할 수 있습니다.

🧪 실습 예제 제안

Orange에서 손글씨 숫자(MNIST) 이미지 데이터를 불러오고, Image Embedding → t-SNE → Image Viewer를 연결하면, 서로 비슷한 숫자가 어떻게 군집(cluster)되는지 볼 수 있어요. 이게 바로 Feature Map이 실전에서 어떻게 작동하는지 시각적으로 확인하는 방법이에요!

- 3처럼 생긴 숫자들이 하나의 공간에 뭉쳐 있다면? CNN이 ‘3’의 특징을 뽑았다는 증거!

- ‘9’와 비슷한 모양의 ‘4’가 엉뚱한 클러스터에 있으면? 학습 데이터의 한계나 분류기의 약점을 보여주는 예!

다음은 오늘 배운 내용을 한눈에 정리해보고, CNN의 핵심 원리를 어떻게 실무에 활용할 수 있을지 이야기해볼게요. 마무리는 항상 인사이트와 함께! 💡

6. 핵심 정리 및 실전 인사이트 💡

지금까지 활성화 맵(Feature Map)과 패딩(Padding)의 개념, 작동 원리, 실전 적용까지 함께 배워봤어요. 혹시 처음엔 어렵게 느껴졌더라도, 지금쯤은 “아~ 그게 그거였구나” 하고 고개를 끄덕이셨을지도 몰라요. 😊

📝 오늘 배운 핵심 요약

- Feature Map은 필터가 이미지에서 감지한 특징을 수치화한 결과물

- Padding은 출력 크기 조정과 가장자리 정보 보존에 필수

- Orange에서는 직접적인 연산은 불가능하지만, 임베딩 → 시각화를 통해 개념 체험 가능

💭 실전에서 어떻게 활용할까?

이 개념들을 이해하고 나면, CNN 구조를 설계하거나 이미지 처리 프로젝트를 할 때 왜 어떤 크기의 필터를 쓰는지, 왜 padding='same'으로 설정하는지 스스로 설명할 수 있게 돼요. 나아가 모델을 더 깊게 쌓거나 성능을 튜닝할 때, 이론에 기반한 선택이 가능해집니다.

그리고 무엇보다 중요한 건, 이 모든 개념들이 결국은 “이미지를 잘 이해하기 위해” 존재한다는 거예요. 사람의 시각 능력을 흉내 내는 CNN에서, Feature Map과 Padding은 눈과 뇌 사이의 연결 다리 같은 존재죠.

🔎 다음 글 예고

다음 시간에는 CNN의 핵심 구성 요소 중 하나인 Pooling 기법(Max Pooling, Average Pooling)에 대해 다룰 거예요. Feature Map을 줄이면서도 중요한 정보는 유지하는, 아주 똑똑한 방식이죠!

여기까지 따라오시느라 정말 수고 많으셨어요! 😊 오늘은 합성곱 신경망(CNN)의 핵심 개념 중 하나인 활성화 맵(Feature Map)과 패딩(Padding)에 대해 깊이 있게 알아봤습니다. 이 두 개념은 CNN이 어떻게 이미지를 이해하고 처리하는지를 결정짓는 아주 중요한 요소입니다. 특히 Orange Data Mining을 활용하면 복잡한 코딩 없이도 이론을 시각적으로 체험하며 학습할 수 있죠.

이번 글을 통해 CNN에 대한 감이 조금이라도 잡히셨다면, 다음 단계로 나아갈 준비가 되신 거예요! 앞으로는 풀링(Pooling), 이미지 분류, 전이 학습까지 하나하나 차근히 다뤄보며 AI의 뼈대를 함께 쌓아가 보아요.

질문이 생기셨거나 실습 중 막히는 부분이 있다면 언제든 댓글이나 메일로 소통해주세요. 여러분과 함께 성장하는 블로그가 되기를 바라며, 다음 글에서 또 만나요! 🙌

'OrangeDataMining' 카테고리의 다른 글

| CNN을 활용한 이미지 분류 실습 (MNIST, CIFAR-10) (0) | 2025.05.05 |

|---|---|

| 풀링(Pooling) 기법 완전 이해하기 – Max Pooling vs Average Pooling (0) | 2025.05.05 |

| CNN의 핵심 개념, 필터와 커널 완벽 이해하기 (0) | 2025.05.04 |

| CNN의 기본 구조 완전 정복: Convolution, Pooling, Fully Connected Layer (1) | 2025.05.04 |

| 합성곱 신경망(CNN) 개요 및 활용 (0) | 2025.05.03 |